Smart Factory & Industrie 4.0

Die Industrie befindet sich inmitten der größten Transformationsphase seit der Einführung von Computern. IoT-Sensorik und flächendeckende Konnektivität generieren exponentiell wachsende digitale Datenmengen, aus deren intelligenter Nutzung sich entscheidende Wettbewerbsvorteile realisieren lassen. Die ganzheitliche datengetriebene Echtzeit-Steuerung und Optimierung von Fabriken und Unternehmen ist keine Vision mehr, sondern wird mehr und mehr zur Pflicht auf dem Weg zu einer nachhaltigen klimaneutralen Produktion.

OmegaLambdaTec unterstützt Industrieunternehmen aller Größen bei der Entwicklung und Umsetzung datengetriebener Industrie 4.0 Innovationen zur Effizienzsteigerung des Kerngeschäfts sowie der Einführung gänzlich neuer digitaler Geschäftsmodelle und Services.

UNSER LEISTUNGSÜBERBLICK

- Automatisierte Echtzeit-Verarbeitung und Analyse von IoT Sensor- und Maschinen-Daten

- Ganzheitliche multidimensionale Planung und Optimierung

- Predictive Maintenance für Maschinen, Assets und Fabriken

- Datenbasierte Bestimmung von Restlebensdauern und Betriebs-Optimierungen für Assets

- Datengetriebene Produktions-Optimierung entlang der gesamten Produktionslinie

- Automatisierte Qualitätssicherung mittels Computer Vision und Deep Learning

- Industrielle Digitale Zwillinge

- Bedarfs-Vorhersagen und Lager-Optimierung

- Datengetriebene Austausch-Optimierung von Assets

- Preis-Forecasting und Einkaufs-Optimierung

- Generierung digitaler 3D-Modelle aus Bestandsplänen

- Echtzeit Signalkabel- und Stromkabel-Monitoring

- Ganzheitliche Konfigurations-Optimierung komplexer Produktions-Anlagen

- Datenbasierte Optimierung von Prozess- und Produktions-Parametern

- Dynamic Pricing und automatisierte Angebotserstellung

- Ganzheitliche KI-basierte Energiekosten-Optimierung

Simulation und Maßnahmen-Optimierung zur Reduzierung des unternehmensweiten

UNSERE AI ENGINE LIBRARIES

- ACHILLES – die Predictive Maintenance, Anomalie-Erkennung und Echtzeit-Monitoring Library

- DYNAMO – die Dynamic Pricing Library für die automatisierte Angebotserstellung

- SPOC – die Forecasting Library für Bedarfs-Vorhersagen und Logistik-Optimierung

- PROMETHEUS – das Szenarien-Simulator-Framework zur langfristigen Geschäfts-Optimierung

- ECOSTAR3 – die DeepTech Library zur Energiekosten-Optimierung, Kosten-Transparenz und Risiko-Management

BEISPIELE FÜR UMGESETZTE ANWENDUNGSFÄLLE AUS UNSERER PRAXIS

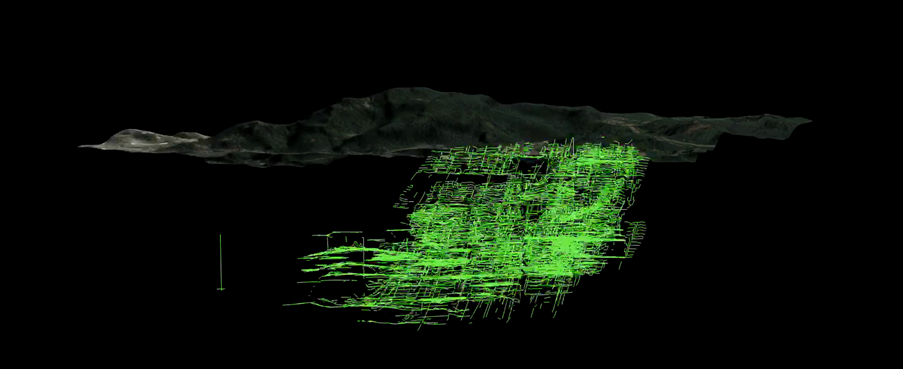

Vollautomatisierte 3D-Modellierung von Steinkohleminen für die RAG

Herausforderung und Ziele

Die RAG besitzt ein Archiv von ca. 160.000 handgezeichneten historischen Minenplänen, die die Entwicklung des Steinkohlebergbaus im Ruhrgebiet und Saarland über die letzten 300 Jahre abbildet. Präzise und schnell verfügbare Informationen, wo genau sich Tunnelstrecken im Untergrund befinden, sind eine essentielle Komponente zur effizienten Bewältigung der heutigen Nachbergbau-Aufgaben und Pflichten der RAG. Zu diesem Zweck sollte eine maßgeschneiderte Lösung entwickelt werden, die aus den Bilddaten der Minenpläne automatisiert alle relevanten Informationen extrahiert und damit voll-digitale 3D-Modelle der Minen zu erzeugt.

OLT-Lösung

- DRIVE Pipeline Entwicklung basierend auf kombinierten Computer Vision, Deep Learning und Physical Analytics Verfahren

- Vollautomatisierte Prozessierung der Minenpläne mit Identifizierung und Extraktion von Tunnelstrecken, Koordinaten und Höhen-Informationen

- Nutzung zusätzlicher Informationen zur automatisierten Korrektur von Koordinaten und Höhen-Informationen

- Automatisierte Kombination aller extrahierter Informationen und Generierung digitaler 3D-Modelle für gesamte Bergwerke

Nutzen

- Zeit- und Kosteneinsparungen um mehr als einen Faktor 100 im Vergleich zur manuellen Digitalisierung der Pläne

- Volldigitale Information aller existierender Tunnelstrecken im Ruhrgebiet und Saarland

- Bewahrung und einfache Nutzung des historischen Wissens auf den Minenkarten für junge Mitarbeiter der RAG

- Neue digitale Möglichkeiten zur automatisierten Risikoanalyse und verbesserte Ansätze zur Schadensvermeidung

- Neue Möglichkeiten für digitale Anwendungen und Services basierend auf präzisen Information der Tunnel-Topologien im Untergrund

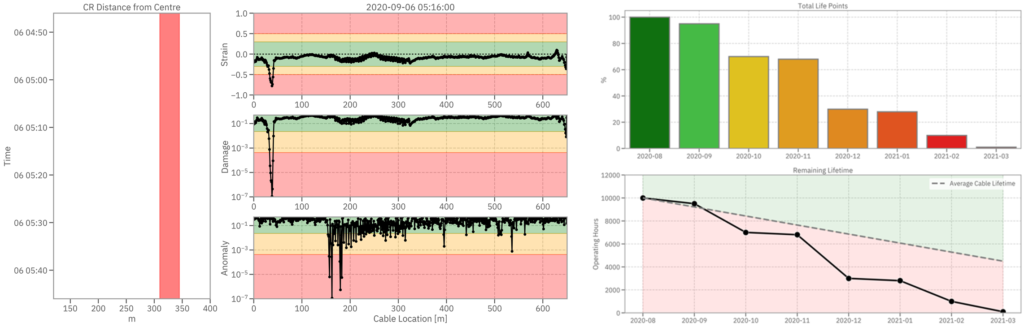

Echtzeit-Monitoring und Predictive Maintenance großer Maschinen Assets

Herausforderung und Ziele

Ungeplante Maschinenausfälle großer Anlagen können Produktionsausfälle nach sich ziehen und dadurch enorme Kosten verursachen, insbesondere wenn kritische Komponenten lange Lieferzeiten haben. Um das zu vermeiden, soll aus den verfügbaren Maschinen-Daten und Sensor-Daten kritischer Komponenten eine prädiktive Monitoring Lösung entwickelt werden, mit der ungeplante Ausfälle vermieden und die Betriebsführung der Maschinen optimiert werden kann.

OLT-Lösung

- Automatisierte Echtzeit-Prozessierung aller Sensor- und Maschinen-Daten

- Automatisierte Anomalie-Detektion und Schadens-Evaluation des Hochspannungskabels im 6 Sekunden Takt

- Datenbasierte Abschätzung der Restlebensdauer kritischer Komponenten

- Root-Cause Analysen zu den Ursachen von auftretenden Störungen und Defekten

- Datenbasierte Betriebsmodus-Optimierung zur Verlängerung der Lebensdauer kritischer Komponenten

Nutzen

- Frühzeitige Identifizierung von Anomalien und Operations-Optimierung der Maschinen-Assets

- Verringerung ungeplanter Ausfallzeiten

- Kostenreduktion durch verlängerte Lebensdauer kritischer Komponenten

- Effizienzsteigerung des Wartungsaufwandes

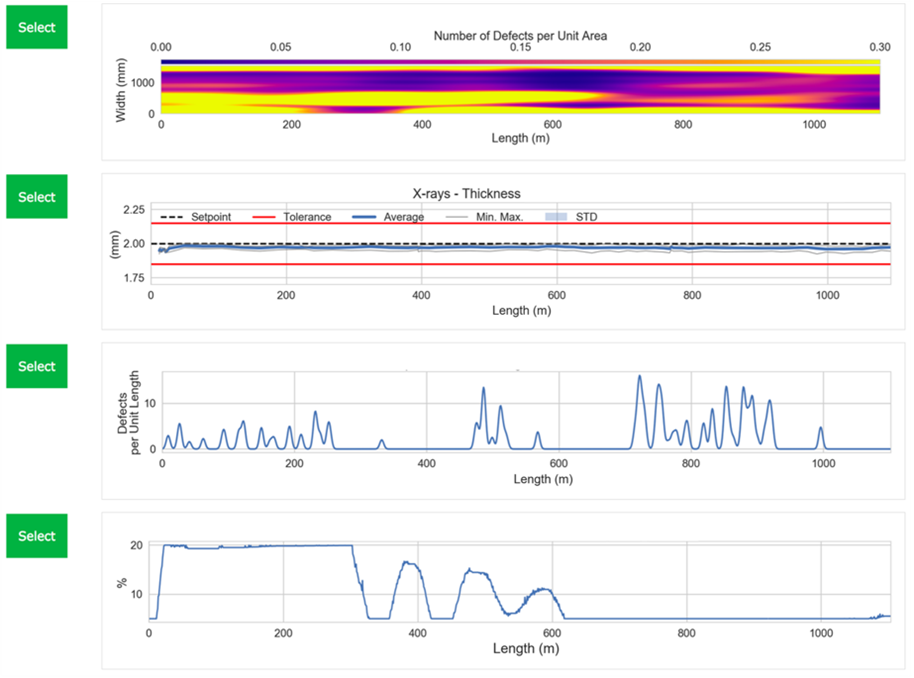

Optimierung der Prozessparameter entlang der gesamten Produktionslinie

Herausforderung und Ziele

Um die Produktionslinie eines neuen Produkts möglichst schnell datengetrieben zu optimieren – und perspektivisch auch in Echtzeit zu steuern – sollen die 50 kritischen Prozessparameter und insgesamt ca. 14000 Messgrößen analysiert und mit resultierenden Qualitäts-KPIs korreliert werden. Eine besondere Herausforderung ist, dass es zum neuen Produktionsprozess noch kaum aufgezeichnete Daten gibt. Ziel ist es, basierend auf dieser Ausgangslage, möglichst schnell eine datenbasierte Optimierung aller kritischen Prozessparameter zu realisieren, um das neue Produkt baldmöglichst mit der gewünschten Qualität und Effizienz produzieren zu können.